“L’IA est la nouvelle électricité.” – Andrew Ng

Comme l’électricité a bouleversé toutes les industries au début du XXe siècle, l’intelligence artificielle s’impose aujourd’hui comme une révolution structurelle. Voitures autonomes, diagnostics médicaux, optimisation logistique, aide à la décision : les cas d’usage se multiplient à une vitesse inédite. D’ici 2030, le marché mondial de l’IA devrait atteindre 826 milliards de dollars1. Mais à mesure que son adoption s’accélère, des enjeux majeurs émergent : sécurité, éthique, transparence.

Cet article propose de décrypter les enjeux, et les solutions déjà à l’œuvre, notamment celles de l’ETSI et d’acteurs pionniers de la tech responsable.

Défi 1 : Pour une IA plus compréhensible

Pourquoi c’est un enjeu ?

- L’IA, de par la complexité de ses algorithmes, fonctionne souvent comme une boîte noire, rendant difficile la compréhension des décisions qu’elle prend.

- Une IA boite noire implique un manque de transparence donc peut engendrer des biais algorithmiques, des erreurs d’interprétation et une perte de confiance des utilisateurs. Cette opacité peut ralentir l’adoption de l’IA dans des domaines critiques comme la santé ou la finance.

- Les réglementations, notamment l’IA Act européen, exigent des systèmes plus explicables et auditables.

Recommandations

Pour améliorer la transparence et l’explicabilité, voici quelques solutions concrètes :

- Responsabiliser les concepteurs : Identifier clairement les parties prenantes responsables des différentes étapes du cycle de vie de l’IA.

- Intégrer des mécanismes d’explicabilité: Utiliser des techniques d’IA explicable (XAI) comme SHAP ou LIME pour expliquer les décisions prises par les modèles d’IA.

- Développer des modèles plus transparents : Favoriser le développement de modèles d’IA plus simples et plus faciles à comprendre.

- Documenter et tracer : Utiliser des outils comme les « Model Cards » ou les « Datasheets for Datasets » (MIT, Google) pour expliciter la provenance des données et les biais potentiels.

- Former les décideurs et utilisateurs : Assurer une formation continue des équipes pour qu’elles comprennent et anticipent les effets de l’IA.

Défi 2 : Biais et Équité dans l’IA

Pourquoi c’est un enjeu ?

- Des décisions non éthiques peuvent nuire à la relation client et à l’engagement des collaborateurs.

- Les systèmes d’IA peuvent hériter des biais présents dans les données d’entraînement. Par exemple, une recherche sur des « grands personnages historiques » mettra en avant des figures uniquement masculines.

- Les biais algorithmiques peuvent conduire à des discriminations involontaires, impactant l’image de l’entreprise et engendrant des risques légaux.

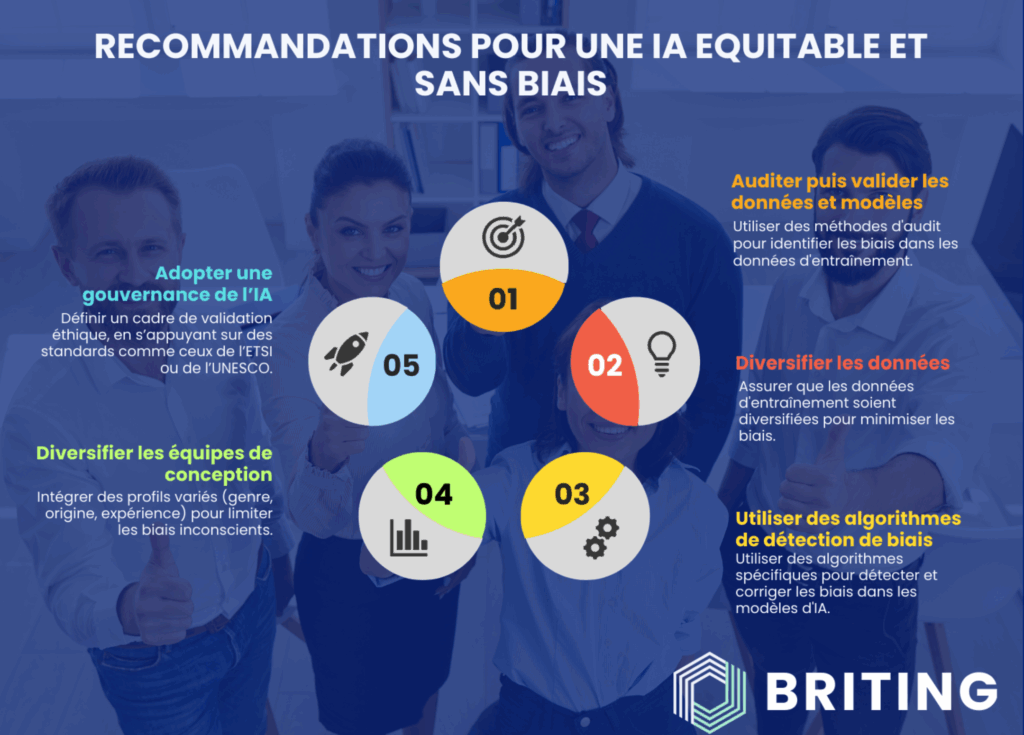

Recommandations

Pour relever ce défi, voici quelques solutions concrètes :

- Auditer puis valider les données et modèles : Utiliser des méthodes d’audit pour identifier les biais dans les données d’entraînement.

- Diversifier les données : Assurer que les données d’entraînement soient diversifiées pour minimiser les biais.

- Utiliser des algorithmes de détection de biais: Utiliser des algorithmes spécifiques pour détecter et corriger les biais dans les modèles d’IA.

- Diversifier les équipes de conception et de développement des IAs : Intégrer des profils variés (genre, origine, expérience) pour limiter les biais inconscients.

- Adopter une gouvernance de l’IA : Définir un cadre de validation éthique, en s’appuyant sur des standards et des recommandations, comme ceux de l’ETSI ou de l’UNESCO.

Défi 3 : Protection des données sensibles

Pourquoi c’est un enjeu?

- L’IA repose sur des volumes massifs de données, souvent sensibles.

- Une fuite ou une mauvaise gestion des données peut avoir des conséquences légales et réputationnelles majeures.

- Différents niveaux de données existent (publiques, personnelles, sensibles), chacun nécessitant une sécurisation adaptée (ETSI GR SAI 009)

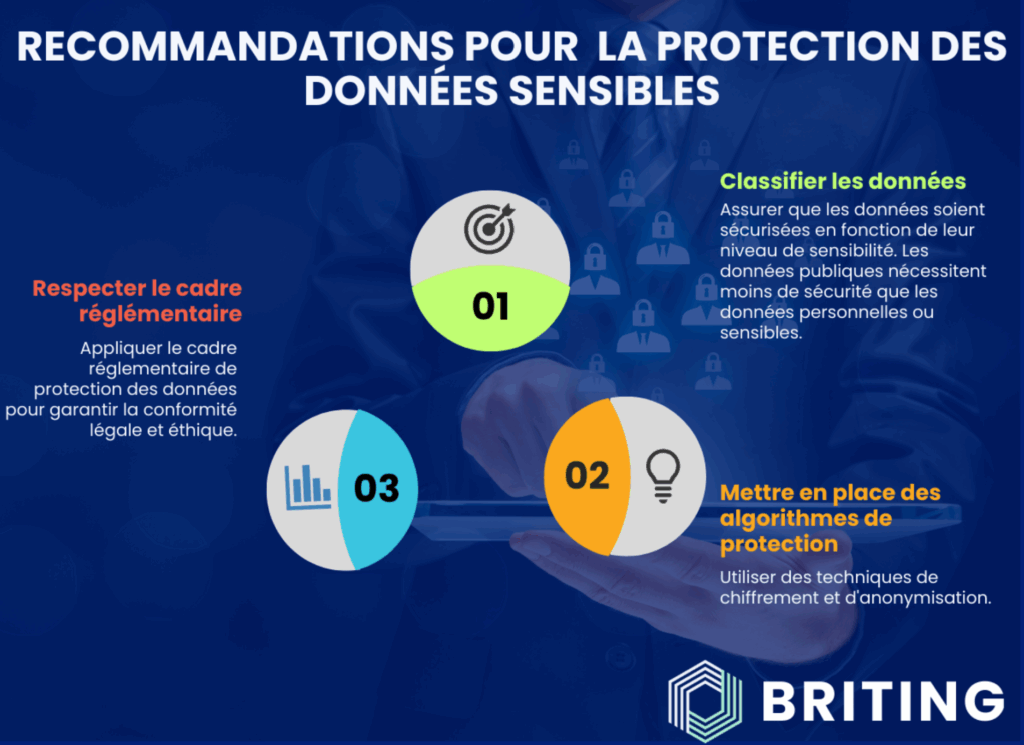

Recommandations

Pour relever ce défi, voici quelques solutions concrètes :

- Classifier les données : Assurer que les données soient sécurisées en fonction de leur niveau de criticité. Le niveau de sécurisation des données va être choisi en fonction de leur criticité :

- Données publiques : Sécurisation minimale.

- Données personnelles standards : Anonymisation et chiffrement de base.

- Données sensibles (santé, finances) : Sécurisation renforcée (Chiffrement avancé, accès restreint… etc)

- Mettre en place des algorithmes de protection adaptés : Utiliser des techniques de chiffrement et d’anonymisation adaptées aux types de données qui sont manipulées par l’algorithme.

- Assurer le respect du cadre règlementaire, tel que le RGPD : Appliquer le cadre normatif de protection des données (RGPD) permet de garantir la conformité légale et éthique.

Défi 4 : Sécurité des Systèmes d’IA

Pourquoi c’est un enjeu ?

Les systèmes d’Intelligence Artificielle, comme tout système informatique, sont vulnérables aux attaques, ce qui peut compromettre la sécurité des données, des infrastructures et des utilisateurs:

- L’IA est vulnérable aux cyberattaques ciblant les données d’entraînement, les données d’interférence, les modèles et les infrastructures (ETSI GR SAI 009)

- La compromission d’un système IA peut avoir des impacts majeurs sur les entreprises.

- Les menaces incluent l’extraction de modèles2, les attaques par empoisonnement de données3 et les failles4 dans le stockage des informations.

- La confiance des clients repose sur une gestion sécurisée de leurs données.

- Des incidents comme le vol de données d’entraînement peuvent compromettre les performances et l’intégrité des modèles IA.

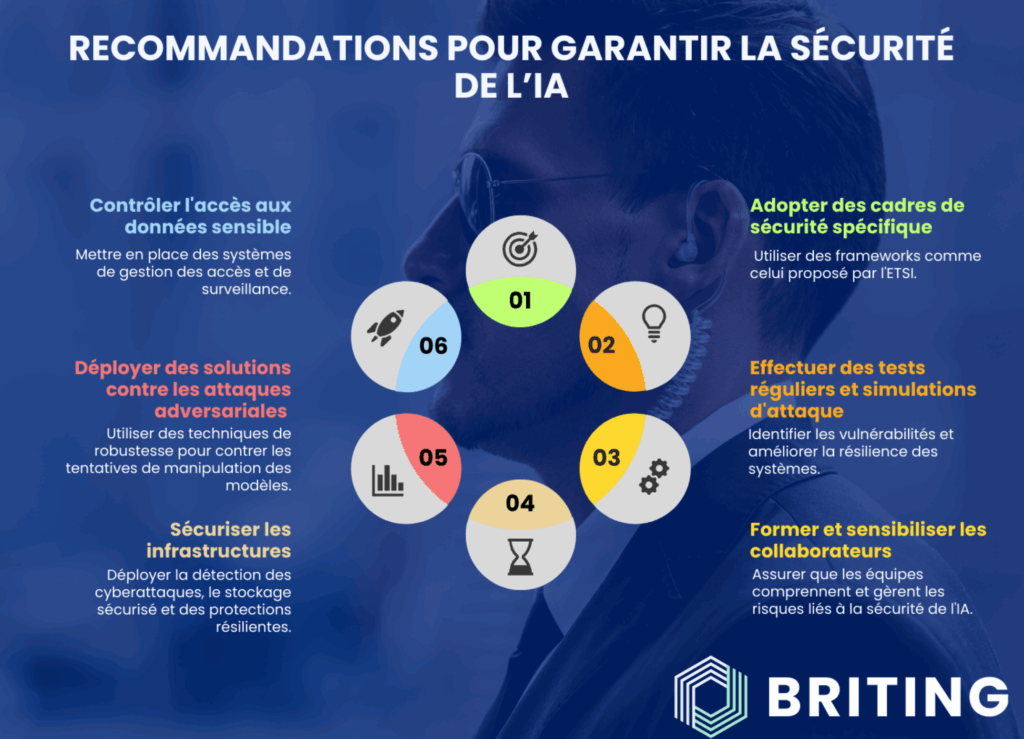

Recommandations

Pour relever ce défi, voici quelques solutions concrètes :

- Adopter des cadres de sécurité appropriés aux données manipulées : Utiliser des frameworks comme celui proposé par l’ETSI (ETSI GR SAI 009), pour sécuriser les plateformes de calcul d’IA. Ces cadres incluent des recommandations pour renforcer la sécurité des systèmes d’IA contre les attaques ciblées.

- Effectuer des tests réguliers et simulations d’attaques (Pentests) : Identifier les vulnérabilités et améliorer la résilience des systèmes.

- Former et sensibiliser les collaborateurs : Assurer que les équipes comprennent et gèrent les risques liés à la sécurité de l’IA.

- Sécuriser les infrastructures :

- Mettre en place des systèmes de détection des cyberattaques (IDS/IPS).

- Utiliser des architectures de stockage réparties et des solutions de backup chiffrées.

- Adopter des systèmes de protection résilients (chiffrement, segmentation des réseaux, surveillance active).

- Déployer des solutions contre les attaques adversariales : Utiliser des techniques de robustesse pour contrer les tentatives de manipulation des modèles.

- Contrôler l’accès aux données sensibles : Mettre en place des systèmes de gestion des accès et de surveillance pour limiter l’accès aux données sensibles et prévenir les fuites de données.

Conclusion: une IA responsable et performante

Face aux défis que pose l’essor de l’intelligence artificielle, des réponses concrètes, ancrées dans la coopération et la régulation, se dessinent. Les cadres de sécurité, d’éthique et de transparence constituent des leviers indispensables pour garantir une adoption de l’IA durable et responsable. En les intégrant dès la conception, les acteurs publics et privés peuvent transformer ces exigences en moteurs de performance. Imaginez un futur où les systèmes d’IA sont non seulement puissants mais aussi transparents, équitables et sécurisés, offrant des opportunités infinies pour l’innovation et le progrès humain. Plutôt qu’une contrainte, l’encadrement de l’IA est un levier de différenciation et d’innovation. Ce futur est à portée de main, et c’est ensemble que nous pouvons le construire. Et vous, êtes-vous prêt à faire confiance à une IA qui place l’humain au cœur de ses priorités ?

1 Selon une étude datant de Novembre 2024 publiée par Statista

2 Définition d’une extraction de modèles : CleverHans Lab – In Model Extraction, Don’t Just Ask ‘How?’: Ask ‘Why?’

3 Définition d’une attaque par empoisonnement : Attaque par empoisonnement (data poisoning attack) | CNIL

4 Définition d’une faille : Faille (Vulnérabilité Informatique) | Glossaire Cyber